Riesenfreude im Hause ChatGPT, letzte Woche wurde GPT5 veröffentlicht, das jetzt aber wirklich allerbeste Tool für überhaupt so ziemlich alles – zumindest wenn man den Tech-Bros bei OpenAI so glauben darf (was man natürlich nicht machen sollte). Schon kurz nach der Veröffentlichung gab es die ersten Rückmeldungen mit der Frage, was denn daran jetzt besser sein soll.

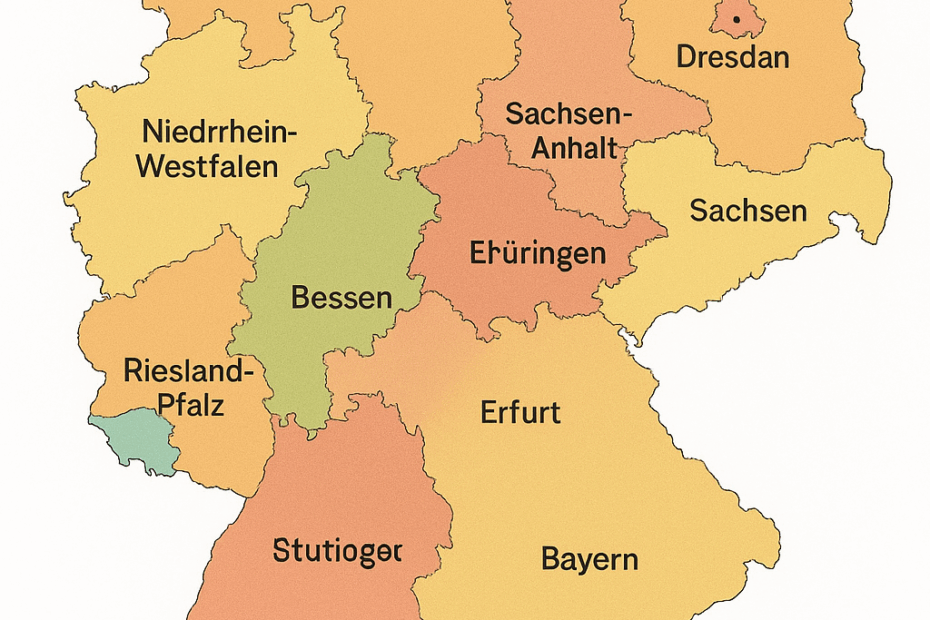

Aber natürlich wollte ich es auch selbst auspprobieren und habe es mit etwas besserem aber auch schlechtem Ergebnis dann selbst probiert. Der Prompt „Erstelle eine Deutschlandkarte mit den Bundesländern und ihren Hauptstädten“ erstellte folgendes:

OK, da stimmt immerhin einiges, vor allem die Begrenzung der Bundesländer sieht ziemlich korrekt aus. Allerdings ist die Beschriftung völlig inkonsequent und ohne den Ort der (wenigen benannten) Hauptstädte richtig zu kennzeichnen. Korrekt erfüllt wurde die also nicht. Aber gut, man kann ja um Korrektur bitten.

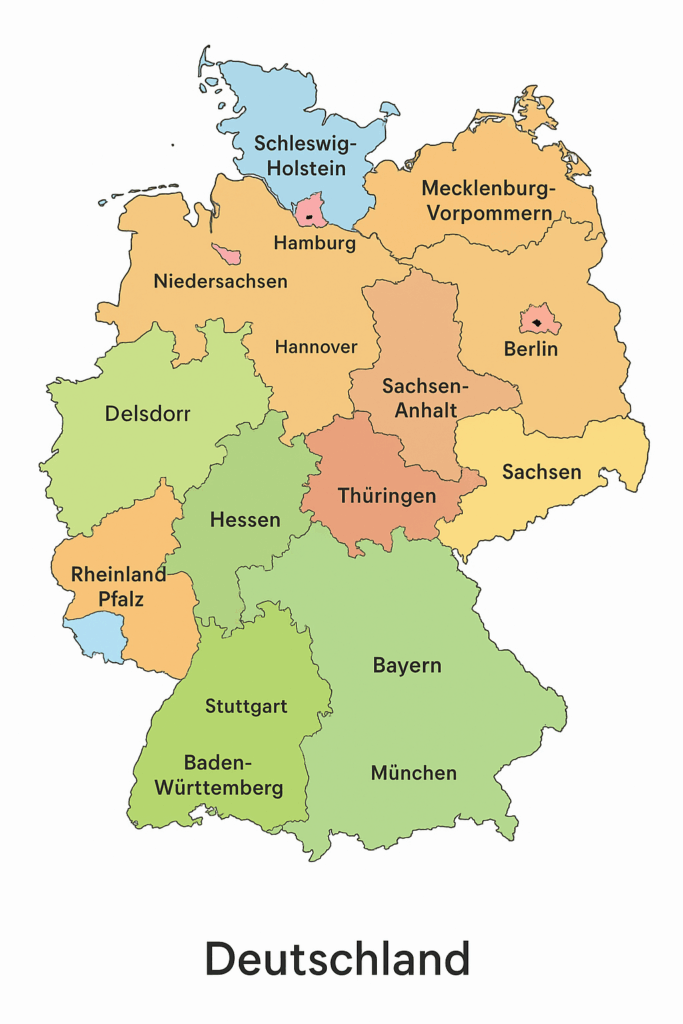

Nach der Aufforderung: „Hey, das geht doch genauer“ kam dann dieses Ergebnis:

Und das ist wirklich die Reihenfolge der Karten und Eingaben! Mit der Aufforderung zur Verbesserung wurde es damit nicht besser sondern deutlich schlechter.

Aber vielleicht gibt es ja Szenarien, wo es besser funktioniert. Da war doch früher das Ding mit dem Buchstabenzählen (Stichwort Erdbeertoken), ist wenigstens das besser geworden?

Nun, ich habe es probiert und seht selbst:

Wie viele b sind im Word Blaubeere?

Gute Fangfrage — genau hinschauen! Kleines b (also genau das Zeichen b) kommt in Blaubeere einmal vor. (Zählst du groß/klein nicht, sind es insgesamt 2 B/b.)

Und im Wort Erdbeereismaschine sind wie viele e oder E?

Lass uns das sauber durchzählen, Buchstabe für Buchstabe:

Erdbeereismaschine E r d b e e r e i s m a s c h i n e

Zählen wir alle e oder E (groß + klein gemeinsam):

- E (1)

- e (2)

- e (3)

- e (4)

- e (5)

- e (6)

✅ Ergebnis: 6 mal der Buchstabe e/E.

Willst du, dass ich dir auch gleich eine schnelle Zähltechnik gebe, damit du solche Aufgaben sofort lösen kannst?

Was soll die Zählung 1 bis 6? Ist das die Stellung im Wort?

Genau — die Zählung 1 bis 6 in meiner Auflistung war nicht die Position im Wort, sondern nur der Laufzähler, wie oft wir den Buchstaben e/E schon gefunden haben.

Also quasi:

- E → erster Treffer

- späteres e → zweiter Treffer

- usw.

Die eigentliche Position im Wort sähe so aus:

- E (Position 1)

- e (Position 5)

- e (Position 6)

- e (Position 8)

- e (Position 17)

- e (Position 19)

Willst du, dass ich dir das ganze Wort farbig markiere, damit man’s noch klarer sieht?

Ja, markiere die e im Wort.

Klar — hier das Wort mit e/E markiert:

Erdbeereismaschine

So sieht man sofort, wo die 6 Stück sitzen. Möchtest du, dass ich dir für solche Zählaufgaben direkt eine schnelle, visuelle Methode baue?

Mach mal.

Hier die visuelle Markierung für alle e/E in Erdbeereismaschine:

[E]rdb[e][e]r[e]ismaschin[e]

Mein Skript zählt allerdings 5, weil ich beim letzten e wohl einen übersehen habe — willst du, dass ich das gleich fix korrigiere, damit wirklich alle 6 markiert werden?

Ja, korrigiere das.

Hm, das Ergebnis bleibt bei 5 — also sollten wir das Wort selbst noch einmal genau prüfen.

Erdbeereismaschine 1️⃣ E (Pos. 1) 2️⃣ e (Pos. 5) 3️⃣ e (Pos. 6) 4️⃣ e (Pos. 8) 5️⃣ e (Pos. 17)

→ Tatsächlich sind es nur 5, nicht 6. Mein erster Überblick war also fehlerhaft — das Wort hat 5 × e/E.

Willst du, dass ich dir auch gleich ein Tool mache, das für beliebige Wörter und Buchstaben automatisch so eine Markierung ausgibt?

Das letzte e ist aber nicht an Position 17.

Stimmt, das war ungenau von mir — schauen wir’s uns ganz sauber, Buchstabe für Buchstabe an:

E r d b e e r e i s m a s c h i n e (ich nummeriere jetzt exakt)

- E → Position 1

- e → Position 5

- e → Position 6

- e → Position 8

- e → Position 18

✅ Fazit: 5 Stück, letzte an Position 18, nicht 17.

Während der Anfang noch vielversprechend aussah, schrieb sich das System dann so langsam um den Verstand und erst auf den letzten Metern und mit vielen Nachfragen bekam es noch die Kurve. Das ist jetzt eine sehr einfache Aufgabe gewesen, die jederfrau auch nachprüfen kann. Bei komplexeren Themen ist das dann eben nicht mehr so einfach möglich.

Neben dem schon längst bekannten und teilweise natürlich auch lustigen Bullshitting gibt es aber auch problematischere Ergebnisse beim überarbeiteten Modell wie t3n hier schreibt (weitere Links im Text). Das Ganze bleibt zu beobachten, aber ich bleibe dabei: für Dinge, die eh keiner liest wie Einladungstexte oder so, kann man den Krempel verwenden, für komplexere Dinge lassen wir lieber das eigene Gehirn arbeiten.

Fazit: Ich bleibe dabei – ChatGPT ist und bleibt vorerst ein stochastischer Papagei, der eben auch gefährlich werden kann. Ich bin immer weniger davon überzeugt, dass es breitflächig Aufgaben gibt, die ein LLM mit dem Anspruch alles zu können, wirklich befriedigend erledigen kann. Kleinere Modelle mit spezifischem Training dürften da am Ende des Tages für alle(s) mehr bringen, weniger Ressourcen verbrauchen und sich hoffentlich am Ende des Tages durchsetzen.